大模型 API 路由器

大模型 API 路由器是一种允许大型语言模型(LLM)调用外部 API 的机制,它通过任务分解和逐步推理的方式,使 LLM 能够根据用户输入生成合适的 API 调用,并处理返回的结果。以下是关于大模型 API 路由器的详细说明:

任务分解与逐步推理

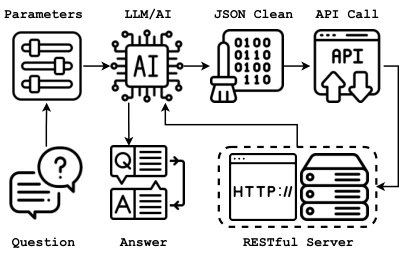

大模型 API 路由器的工作流程通常包括任务分解和逐步推理。例如,在图 1 中,参数通过 LLM 处理,生成问题和答案,然后将这些结果转换为 JSON 格式,进一步发送给 RESTful 服务器。这种机制使得 LLM 能够处理复杂的任务,而不仅仅是简单的文本生成。

API 调用流程

当用户发出请求时,LLM 会根据请求生成一个请求,并将其发送到 API 数据库。API 数据库根据请求生成一个 API 调用和权限范围,然后将请求转发给秘密凭证存储。秘密凭证存储授权后返回一个令牌,LLM 使用该令牌执行 API 调用。最后,API 数据库将执行结果返回给 LLM,LLM 再将结果返回给用户。

API 调用的频率与数据格式转换

在设计大模型与 API 的接口时,需要考虑 API 调用的频率和数据格式转换。API 调用的频率需要根据 API 的速率限制进行设计,以避免超过 API 的调用限制。此外,API 返回的数据格式可能与大模型需要的数据格式不一致,因此需要进行数据格式转换。API 调用的示例

以 OpenAI 的 ChatGPT 为例,可以通过 Python 的 requests 模块向 OpenAI 的 API 发送 POST 请求,请求头中包含注册的 API 密钥,请求体中包含模型名称和消息(prompt)信息。此外,还可以使用大模型厂商提供的 API,如通过 openai 的 Completion 和 ChatCompletion 接口调用模型,分别用于文本生成和问答。API 调用的优化

为了提高 API 调用的效率和稳定性,可以设置合理的调用频率,并在必要时进行调用频率的调整。例如,可以通过缓存机制减少对 API 的频繁调用,从而提高调用效率和稳定性。API 调用的安全性

在 API 调用过程中,安全性是一个重要的考虑因素。需要确保 API 密钥的安全存储和传输,防止未经授权的访问。此外,还需要对 API 返回的数据进行验证,以防止数据泄露或篡改。API 调用的扩展性

大模型 API 路由器的设计需要具备良好的扩展性,以便支持更多的 API 服务。例如,可以选择不同的多模态大模型通过不同的 API 提供服务,选择合适的 API 是关键。API 调用的调试与测试

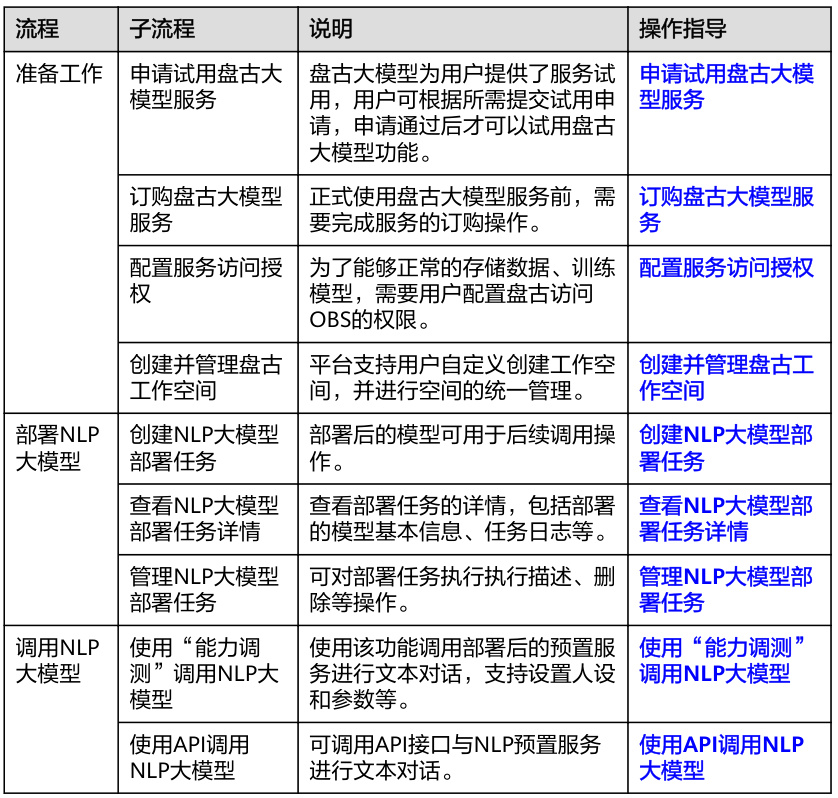

在开发过程中,需要对 API 调用进行调试和测试,以确保其正常运行。例如,可以使用“能力调试”功能调用 NLP 大模型,并通过 API 调用 NLP 大模型,以验证其功能和性能。

API 调用的文档与支持

大模型 API 路由器的使用需要参考详细的文档和指南。例如,腾讯云的大模型知识引擎 API 文档提供了调用方式、请求结构、服务地址等详细信息,帮助用户更好地理解和使用 API。API 调用的未来展望

随着大模型技术的不断发展,API 调用的方式和应用场景也在不断扩展。例如,Toolformer 模型通过简单的 API 和少量演示,使 LLM 能够自我学习使用外部工具,从而实现最佳的零样本性能。未来,API 调用可能会更加智能化和自动化,为用户提供更高效的服务。

综上所述,大模型 API 路由器通过任务分解、逐步推理、API 调用、数据格式转换、安全性、扩展性、调试与测试、文档与支持以及未来展望等多个方面,实现了大模型与外部 API 的有效交互,为用户提供了更加灵活和强大的服务。